NVIDIA 豪擲 200 億美元挖走 Groq 團隊:黃仁勳對於推論時代的豪賭

Nvidia 200 億美元收購 Groq,挖走設計 Google TPU 的 Jonathan Ross。深度解析黃仁勳的推論戰略、Groq LPU 技術突破、Acqui-hire 趨勢,以及 AI 從訓練轉向推論的產業變革。推論速度快 10 倍、能耗降 90%,AI 晶片戰爭進入新階段。

12 月 24 日,平安夜。

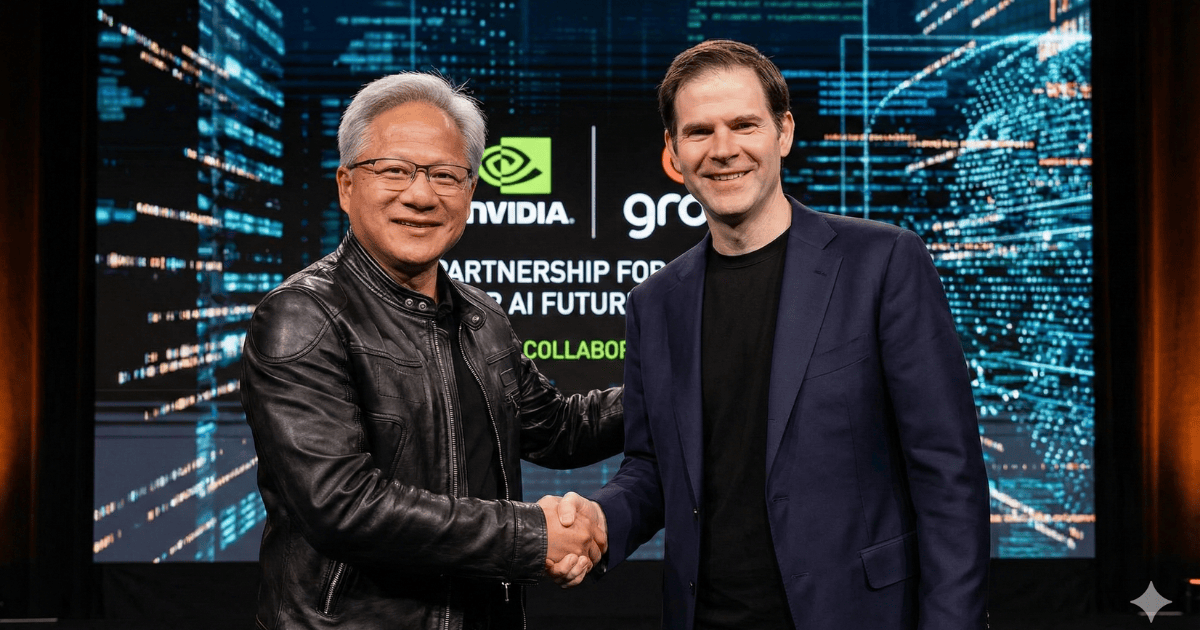

當矽谷大部分人都在享受假期時,CNBC 突然爆出一條震撼消息:全球市值第一的 NVIDIA 斥資 200 億美元,收購 AI 晶片新創 Groq。

200 億美元是什麼概念?這是 NVIDIA 有史以來最大的單筆交易,是 2019 年收購 Mellanox的三倍左右。更誇張的是,Groq 在今年 9 月的估值才 69 億美元,三個月不到,身價暴漲近三倍。

但幾小時後,Groq 發文澄清:這不是「收購」,而是「技術授權協議」。

真相逐漸浮出水面:

NVIDIA 用 200 億美元買走的,不是一家公司,而是一個團隊。主要成員是曾參與 Google TPU 設計的 Jonathan Ross 以及工程團隊,還有他手上那個能讓推論速度快 10 倍、能耗降 90% 的 LPU 晶片技術。

這或許是黃仁勳對於近期 GPU 與 TPU 之爭的最直接回應。

大學輟學的天才,打造了 Google 的秘密武器 TPU

要理解這筆交易的價值,必須先認識 Jonathan Ross 這個人。

從大學輟學到頂尖計算機科學研究中心

Jonathan 的經歷堪稱傳奇。他從大學輟學,卻靠自學和旁聽課程,最終進入紐約大學 Courant Institute——全球頂尖的數學和計算機科學研究中心。

Jonathan 在這過程中不僅掌握了深度學習的理論基礎,更重要的是,他學會了一種思維方式:如何為特定的計算任務設計專用硬體架構。

這個思維方式,後來改變了 AI 晶片的歷史。

「20% 項目」催生的 TPU 革命

2011 年,Jonathan 加入 Google。在那裡,他發起了一個最初只是「20% 項目」的內部創新計劃——Google 允許員工用 20% 的時間做自己感興趣的事。

Jonathan 的想法很簡單:GPU 是為圖形渲染設計的,為什麼我們要用它來做 AI 運算?為什麼不專門為 AI 設計一個晶片?

這個想法後來演變成廣為人知的 Tensor Processing Unit(TPU)——Google 為 AI 工作負載量身打造的專用晶片。

Jonathan 親自設計並實現了第一代 TPU 的核心架構。這個晶片有多重要?它讓 Google 在 AI 訓練和推論上,不再完全依賴 Nvidia 的 GPU,打破了 Nvidia 在 AI 晶片市場的壟斷地位。

2016 年,AlphaGo 擊敗李世乭,震驚世界。而驅動 AlphaGo 的,正是 Jonathan 參與設計的 TPU。

2016 年出走:從 Google 到 Groq

就在 TPU 開始嶄露頭角的時候,Jonathan 做了一個令人意外的決定:離開 Google,創立 Groq。

他帶走了一群前 Google 工程師,都是 TPU 的核心班底。

Jonathan 想做的,不是再造一個 TPU,而是要解決一個更大的問題:當 AI 從訓練走向應用,當推論成為主要工作負載,什麼樣的晶片才是最優解?

這個問題的答案,就是 Groq LPU。

LPU:重新定義推論的遊戲規則

2024 年初,當 Groq 首款 LPU 亮相時,整個 AI 圈都震驚了。

500 token/秒:秒殺 ChatGPT 的速度

測試結果令人難以置信:Groq 一秒可以輸出 500 個 token,是當時世界上速度最快的 LLM 推論系統。

什麼概念?ChatGPT 的回覆速度大約是 20-40 token/秒。Groq 直接快了 10 倍以上。

更誇張的是成本和能耗:

- 單卡價格:2 萬美元(比高階 GPU 便宜)

- 推論速度:比 Nvidia GPU 快 10 倍

- 能耗:只有傳統方案的 1/10

這意味著,在推論任務上,Groq LPU 能以更低的成本、更快的速度、更少的能耗,提供遠超 GPU 的性能。

TISC 架構:避開 GPU 的致命缺陷

Groq 的突破源於一個根本性的洞察:

GPU 是為圖形渲染設計的,它的架構並不適合 AI 推論。

傳統 GPU 需要頻繁地從高帶寬記憶體(HBM)中載入資料。這就像是一個廚師,每做一道菜都要跑到倉庫去拿食材,來回跑的時間比做菜的時間還長。

Groq 開創了一種全新的架構:時序指令集計算機(Temporal Instruction Set Computer, TISC)。

這個架構的核心思想是:讓資料流動起來,而不是讓運算單元去追資料。

具體來說:

- 無需像 GPU 那樣依賴 HBM,避免了記憶體瓶頸

- 每個時鐘週期都能被有效利用,沒有等待時間

- 延遲穩定在個位數毫秒,遠優於 GPU 的數十毫秒

更重要的是,Groq 實現了多個 TSP(Tensor Streaming Processor)的無縫鏈接。這意味著,隨著更多 LPU 的加入,性能可以線性擴展——加 10 張卡,性能就提升 10 倍,沒有 GPU 集群常見的通訊瓶頸。

如果把 GPU 比作是一群各自為政的將軍,Groq LPU 就是一支訓練有素的軍隊,每個士兵都知道自己該在什麼時候做什麼事。

黃仁勳的推論焦慮

那麼,NVIDIA 為何要在此時出手?答案藏在黃仁勳今年初的一句話裡。

「推論需求將增長十億倍」

2025 年初,黃仁勳在採訪中說:「推論需求未來將增長高達十億倍。」

這不是隨口說說。數據支撐了他的判斷:

根據 OpenRouter × a16z 分析 2025 年 100 兆 tokens 的「AI 現狀」研究,目前經推理優化的模型承載的 token 佔比已超過 50%,成為高價值任務的預設選項。

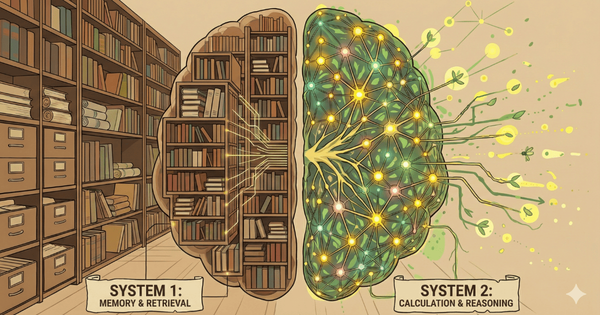

更關鍵的是,AI 正在從「單次生成」轉向「推理時計算」(Inference-time Compute)。OpenAI 的 o1 模型、DeepSeek R1 等推理模型,會在回答前進行長時間的「思考」(推論),這讓推論算力需求進一步暴增。

AI 的主戰場,正在從「訓練」轉向「推論」。

訓練壟斷,推論受困

問題是,NVIDIA 在這兩個戰場的處境截然不同。

訓練市場:NVIDIA GPU 幾乎壟斷,市佔率超過 80%。

推論市場:面臨 Google TPU、AMD、專用 ASIC 的圍剿,GPU 的優勢正在消失。

為什麼?因為訓練和推論是兩種完全不同的計算任務。

訓練需要大量並行運算、高頻寬記憶體,GPU 在這方面無人能敵。但推論需要的是低延遲、高吞吐、能耗效率——這正是 GPU 的弱點,卻是 TPU、LPU 等專用晶片的強項。

更糟的是,Google 的 TPU 正在崛起。隨著 Google Gemini 和 Ironwood TPU 的發布,Google 在推論市場的表現越來越強勢。市場上甚至出現了「Google vs NVIDIA」的生態分化。

黃仁勳意識到,如果不在推論市場補齊短板,Nvidia 可能會重蹈 Intel 的覆轍——在舊時代的優勢,成為新時代的包袱。

200 億美元的防禦性收購

這就是 NVIDIA 收購 Groq 的真正原因。

黃仁勳在交易後向員工發送的內部郵件(被 CNBC 曝光)中,直接點明了戰略意圖:

「我們計劃將 Groq 的低延遲處理器整合到 NVIDIA 的 AI 工廠架構中,以服務更廣泛的 AI 推論和即時工作負載。」

關鍵字:推論、低延遲、即時工作負載。

這是一步防禦性收購:

- 拿下 Groq 的 LPU 技術,補齊推論端的缺點

- 挖走 Jonathan Ross——Google 陣營裡最懂專用晶片設計的人

- 阻止 Groq 成為下一個威脅 NVIDIA 的「推論之王」

NVIDIA 不是在買一家公司,而是在買未來的門票。

科技巨頭的新玩法:「Acqui-hire」

NVIDIA 收購 Groq,並非孤例。過去兩年,科技巨頭掀起了一波「Acqui-hire」(人才收購)浪潮。

為何流行?

傳統併購流程漫長,監管審查嚴格。尤其是反壟斷法日益收緊的今天,任何大型交易都可能耗時數年。

但「Acqui-hire」妙就妙在:

- 名義上不是「收購」:而是「技術授權」或「合作」

- 原公司繼續運營:降低監管風險

- 快速拿到核心資產:技術和人才,幾個月就能到位

這就像是包養一個明星工作室,而不是直接買下整個演藝公司。

2024-2025 年重大案例

2024 年 3 月:微軟 × Inflection(6.5 億美元)

- 挖走 Mustafa Suleyman(DeepMind 聯合創始人)和核心團隊

- Inflection 的 AI 模型技術授權給微軟

2024 年 8 月:Google × Character.AI(27 億美元)

- 請回 Transformer 論文作者 Noam Shazeer 及 30 多人核心團隊

- 用於強化 Gemini

2025 年 6 月:Meta × Scale AI(150 億美元)

- 挖走創辦人和核心工程師團隊

- Scale AI 裁員,調整業務方向

2025 年 7 月:Google × Windsurf(24 億美元)

- 挖走 Varun Mohan 和 Douglas Chen 及研發團隊

- 幾個月後推出 AI 編程工具 Antigravity

下一個目標是誰?

Intel 正在洽談收購 SambaNova:

- Intel CEO 陳立武曾擔任 SambaNova 執行董事長

- 已簽不具約束力的意向書

Cerebras 撤回 IPO,完成 10 億美元融資:

- 原計劃上市,10 月突然撤回

- 是否在等待被收購?

這波 Acqui-hire 浪潮背後的邏輯很清楚:在 AI 時代,頂尖人才是最稀缺的資源,誰掌握了人才,誰就掌握了未來。

推論時代的降臨

NVIDIA 史上最大的交易,傳遞了一個清晰的訊號:

AI 的黃金時代,正在從「訓練」轉向「推論」。

從 Scaling Law 到推論優化

吳恩達(Andrew Ng)曾明確指出:「訓練基礎設施護城河脆弱,推論算力供不應求。」

為什麼?因為訓練是一次性投資,推論是持續性消耗。

訓練一個 GPT-4 級別的模型,可能需要幾千萬美元、幾萬張 GPU、幾個月時間。但訓練完成後,每一次使用者與 ChatGPT 對話,都是推論。每一次 AI 生成圖片,都是推論。每一次自動駕駛做決策,都是推論。

更重要的是,田淵棟(前 Meta FAIR 研究總監)的研究揭示:長思維鏈會改變 Scaling Law。

「如果一個問題有很長的思維鏈,你就會讓模型的 Scaling Law 的曲線變得非常 nice。我可以用 1/10 的樣本、1/10 的參數,獲得更好的效果。」

這意味著,AI 的未來不是訓練更大的模型,而是給模型更多時間「推論」。就像考試時給學生 10 倍的作答時間,一個中等大小的模型,如果讓它在回答前「思考」更久,表現就能超過一個「秒答的超大模型。

從「注意力經濟」到「意圖經濟」

這不只是技術路線的轉變,更是商業模式的重構。

從 Perplexity 到豆包手機,從 OpenAI 成立 AAIF 推動 Agent 標準化,到馬斯克預言「手機將不再有 App」——這些都指向同一個方向:從「注意力經濟」到「意圖經濟」。

在注意力經濟時代,平台靠用戶停留時長賣廣告。在意圖經濟時代,AI Agent 直接完成任務,用戶不再需要打開 App、瀏覽廣告、被演算法餵養。

這背後靠的,就是強大的推論能力。

推論,是 AI 時代的新石油

12 月 24 日的這筆交易,不只是一個商業新聞,更是一個時代的註腳。

當黃仁勳說「推論需求將增長十億倍」,他看到的是一個全新的市場。訓練市場的規模可能有天花板,而推論市場才剛剛開始。

Groq LPU 能以 10 倍的速度、1/10 的能耗完成推論任務。這不是漸進式的改良,而是範式級的創新。NVIDIA 花 200 億美元買下 Jonathan Ross 和他的團隊,就是要確保自己在這個新時代不會掉隊。

而對投資者、創業者、技術從業者來說,這個訊號再清楚不過:

推論,是 AI 時代的新石油。誰掌握了推論的效率,誰就掌握了未來。

延伸閱讀

為什麼推論變得如此重要?這邊有過去的相關分析

- 從擴展定律到世界模型,人工智慧模型演進的下一個商機:吳恩達認為訓練層恐有泡沫,推論供不應求

- 從 Perplexity 到豆包手機,「注意力經濟」到「意圖經濟」的市場重構:Agent 時代來臨,AI 從對話走向執行

- 2025 年人工智慧發展現狀:代理推理崛起、開源模型突圍、應用場景分化與灰姑娘效應:推論時計算佔比已超過 50%

那麼,在推論時代,什麼才是真正的護城河?

下一篇文章將深入探討:算力調度與向量資料庫如何成為 AI 基礎設施的新賣鏟人。

參考資料

新聞報導:

- CNBC (2025). "Nvidia buying AI chip startup Groq for about $20 billion"

- Bloomberg (2025). "Nvidia Reaches Licensing Deal With Chip Startup Groq"

- Reuters (2025). "Nvidia to buy AI chip startup Groq for about $20 billion"

技術文檔:

- Groq 官方技術論文:"A Software-defined Tensor Streaming Multiprocessor for Large-scale Machine Learning"